« The Gatekeepers » d'Ali Banisadr, (né à Téhéran en 1976, vit et travaille à New York), huile sur lin, 72 x 108 pouces (2010). reproduit avec l'accord gracieux de l'artiste. <

<

Andy Lee Roth

Les algorithmes, des programmes d'intelligence artificielle contrôlés par les grandes entreprises technologiques telles que Google, Facebook et Twitter - des sociétés qui n'ont aucun engagement envers le journalisme éthique - sont les nouveaux gardiens de l'information. De plus en plus, ce sont des algorithmes propriétaires, plutôt que des rédacteurs en chef, qui déterminent les nouvelles qui circulent le plus largement, ce qui soulève de sérieuses inquiétudes quant à la transparence et à la responsabilité dans la détermination de l'intérêt des nouvelles.

L'essor de ce que l'on peut considérer comme une censure algorithmique rend à nouveau pertinent le vieux concept de "contrôle d'accès" d'une manière qui s'attaque directement aux critiques précédentes sur la façon dont nous obtenons nos informations. Pour illustrer le pouvoir des algorithmes à contrôler le flux d'informations, prenons l'exemple de ce qui est arrivé à l'enregistrement numérique d'une conférence universitaire à laquelle j'ai assisté l'année dernière.

YouTube et la Conférence des Amériques sur l'éducation aux médias critiques

En octobre 2020, j'ai participé à une conférence universitaire consacrée à l'éducation aux médias. L'événement a rassemblé les principales personnalités du domaine pour deux jours de panels et de discussions savantes. De nombreux participants, y compris ceux d'une session que j'ai modérée, ont soulevé des questions sur l'impact des entreprises Big Tech telles que Google et Facebook sur l'avenir du journalisme et ont critiqué la façon dont les médias d'entreprise- y compris non seulement Fox News et MSNBC mais aussi le New York Times et le Washington Post - imposent souvent des définitions étroites de l'actualité. En d'autres termes, la conférence ressemblait à beaucoup d'autres auxquelles j'ai participé, sauf qu'en raison de la pandémie, nous nous sommes rencontrés virtuellement via Zoom.

Une fois la conférence terminée, ses organisateurs ont téléchargé les enregistrements vidéo de la session principale et de plus de vingt heures supplémentaires de présentations de la conférence sur une chaîne YouTube créée pour rendre ces sessions accessibles à un plus large public.

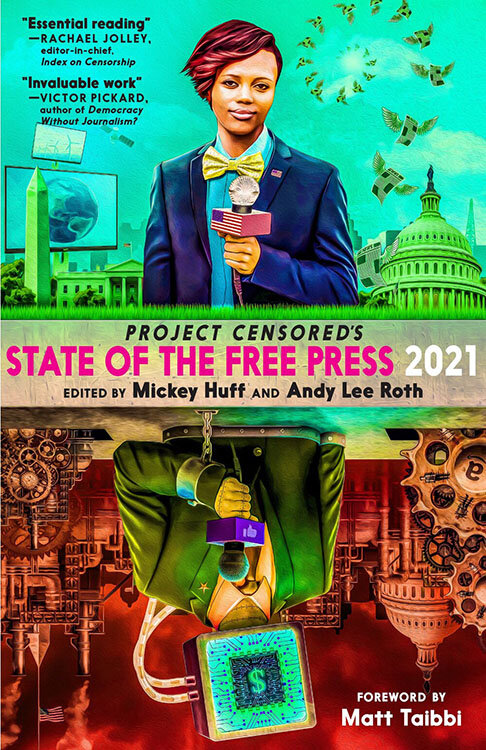

Le projet Censuré État de la presse libre | 2021 étudie "le paysage désolé des reportages d'entreprise, où des forces puissantes s'entrecroisent pour restreindre la libre circulation de l'information...".

<

<

Plusieurs semaines plus tard, YouTube a supprimé toutes les vidéos de la conférence, sans aucune notification ni explication aux organisateurs de la conférence. Comme le rapporte MintPress News, une conférence universitaire au cours de laquelle de nombreux participants ont lancé des avertissements sur "les dangers de la censure des médias" a, ironiquement, "été censurée par YouTube". Malgré les appels formels lancés par les organisateurs, YouTube a refusé de restaurer le contenu supprimé et a refusé de reconnaître que le contenu avait été publié.

Grâce à mon travail avec Project Censored, un organisme de surveillance de l'information à but non lucratif qui jouit d'une réputation mondiale pour son opposition à la censure de l'information et sa défense de la liberté de la presse, je connaissais bien le filtrage des contenus en ligne. Penser au pouvoir de YouTube de supprimer l'enregistrement vidéo public d'une conférence universitaire, sans explication, m'a d'abord rappelé les "trous de mémoire" de l'ouvrage de George Orwell, Nineteen Eighty-Four. Dans le roman dystopique d'Orwell, les trous de mémoire éliminent efficacement, pour les détruire, toute preuve susceptible d'aller à l'encontre des intérêts du gouvernement, tels que déterminés par le ministère de la Vérité.

Mais je me suis également souvenu d'une théorie de la production et de la distribution des informations qui a connu une certaine popularité dans les années 1950, mais qui est tombée en disgrâce depuis. J'en suis venu à comprendre la suppression des vidéos de la conférence par YouTube comme (une nouvelle forme de) gatekeeping — le concept développé par David Manning White et Walter Gieber dans les années 1950 pour expliquer comment les rédacteurs en chef des journaux déterminaient quelles histoires publier comme nouvelles.

Le modèle original de gatekeeping

M. White a étudié les décisions d'un rédacteur en chef d'un petit journal du Midwest, en examinant les raisons que le rédacteur en chef, que M. White appelle "M. Gates", donne pour sélectionner ou rejeter des articles spécifiques pour la publication. M. Gates a rejeté certains articles pour des raisons pratiques - "trop vague", "écriture ennuyeuse" ou "trop tard - pas d'espace". Mais dans 18 des 423 décisions examinées par White, M. Gates rejetait des articles pour des raisons politiques, les qualifiant de "pure propagande" ou de "trop rouges", par exemple. M. White conclut son article de 1950 en soulignant "à quel point la communication des "nouvelles" est hautement subjective, basée sur l'ensemble des expériences, des attitudes et des attentes du contrôleur".

En 1956, Walter Gieber a mené une étude similaire, en examinant cette fois les décisions de 16 rédacteurs en chef différents. Les résultats de Gieber réfutent la conclusion de White selon laquelle le gatekeeping est subjectif. Au contraire, Gieber a constaté que, indépendamment les uns des autres, les rédacteurs prenaient à peu près les mêmes décisions. Le gatekeeping était réel, mais les rédacteurs traitaient la sélection des articles comme une tâche routinière, et ils étaient surtout préoccupés par ce que Gieber a décrit comme les « objectifs de production » et la « routine bureaucratique » — et non, en d'autres termes, par la promotion d'un programme politique particulier. Des études plus récentes ont renforcé et affiné la conclusion de Gieber selon laquelle l'évaluation professionnelle de l'intérêt de l'information, et non la partisannerie politique, guide les décisions des travailleurs de l'information quant aux sujets à couvrir.

Le modèle du gatekeeping est tombé en désuétude à mesure que de nouveaux modèles théoriques — dont le « cadrage » et la « définition de l'agenda » — semblaient expliquer une plus grande partie du processus de production des informations. Dans un article influent de 1989, le sociologue Michael Schudson décrit le gatekeeping comme « une métaphore pratique, mais pas tout à fait appropriée ». Le modèle du gatekeeping est problématique, écrit-il, car « il laisse l'"information" sociologiquement intacte, un matériau vierge qui arrive à la porte déjà préparé ». Dans cette vision erronée, les « nouvelles » sont préformées, et le gardien « décide simplement quels éléments de nouvelles préfabriquées seront autorisés à franchir le portail ». Bien que White et d'autres aient noté que le « contrôle d'accès » se produit à de multiples étapes du processus de production de l'information, la critique de Schudson s'est maintenue.

Avec l'avènement d'Internet, certains chercheurs ont tenté de faire revivre le modèle du gatekeeping. De nouvelles études ont montré que les publics agissent de plus en plus comme des gardiens, décidant des nouvelles à transmettre via leurs propres comptes de médias sociaux. Mais, dans l'ensemble, le gatekeeping semble encore plus dépassé : « Internet défie toute notion de "porte" et remet en question l'idée que les journalistes (ou qui que ce soit d'autre) puissent ou doivent limiter ce qui y passe », écrivait Jane B. Singer en 2006.

Filtrage algorithmique des informations

Aujourd'hui, l'évaluation optimiste de Singer semble plus dépassée que la théorie du gatekeeping elle-même. Au contraire, l'internet, et les médias sociaux en particulier, englobent de nombreuses « portes » limitatives, dont de moins en moins sont gérées par les organismes de presse ou les journalistes eux-mêmes.

Des incidents tels que la suppression totale par YouTube des vidéos de la conférence sur l'éducation aux médias ne sont pas isolés ; en fait, ils sont de plus en plus fréquents, car les entreprises privées et leurs plateformes médiatiques exercent un pouvoir toujours plus grand pour réglementer qui s'exprime en ligne et les types de discours qui sont autorisés.

Des organes d'information indépendants ont montré comment Twitter, Facebook et d'autres ont suspendu des comptes vénézuéliens, iraniens et syriens et censuré des contenus contraires à la politique étrangère des États-Unis ; comment l'agrégateur Google News filtre les articles pro-LGBTQ tout en amplifiant les voix homophobes et transphobes; et comment les modifications apportées par Facebook à son fil d'actualité ont réduit le trafic web vers les organes d'information progressistes.

Les décisions de certaines entreprises de la Big Tech ont fait la une des journaux. Après l'élection présidentielle de 2020, par exemple, Google, Facebook, YouTube, Twitter et Instagram ont restreint les communications en ligne de Donald Trump et de ses partisans ; après l'assaut du 6 janvier contre le Capitole, Google, Apple et Amazon ont suspendu Parler, la plateforme de médias sociaux privilégiée par de nombreux partisans de Trump.

Mais les décisions de déplafonner Donald Trump et de suspendre Parler diffèrent à deux égards fondamentaux de la plupart des autres cas de réglementation du contenu en ligne par les entreprises de la grande technologie. Premièrement, les cas impliquant Trump et Parler ont fait l'objet d'une large couverture médiatique ; ces décisions sont devenues des questions publiques et ont été débattues comme telles. Deuxièmement, comme cette couverture médiatique l'a tacitement transmis, les décisions de restreindre la voix en ligne de Trump et la portée en réseau de Parler ont été prises par les dirigeants de Google, Facebook, Apple et Amazon. Il s'agissait de décisions humaines.

« Thought Police » par Ali Banisadr, huile sur lin, 82 x 120 pouces (2019). reproduit avec l'accord gracieux de l'artiste. <

<

Ce dernier point n'était pas au centre de la couverture médiatique qui en a résulté, mais il est très important pour comprendre les enjeux dans d'autres cas, où la décision de filtrer le contenu — en fait, de faire taire les voix et d'étrangler les conversations — a été prise par des algorithmes, plutôt que par des humains.

De plus en plus, les nouvelles que nous rencontrons sont le produit à la fois des routines quotidiennes et des jugements professionnels des journalistes, des rédacteurs et des autres professionnels de l'information , et des évaluations de la pertinence et de l'adéquation effectuées par des programmes d'intelligence artificielle qui ont été développés et sont contrôlés par des sociétés privées à but lucratif qui ne se considèrent pas comme des entreprises de médias et encore moins comme des entreprises de journalisme. Lorsque je recherche des informations sur les « lapins à l'état sauvage » ou sur la loi sur l'égalité sur Google News, un algorithme utilise une série de critères confidentiels pour déterminer quels articles et sources d'information apparaissent en réponse à ma requête. Google News ne produit pas d'informations par lui-même, mais, à l'instar de Facebook et d'autres plateformes qui fonctionnent comme des agrégateurs d'informations, il joue un rôleénorme — et mal compris — dans la détermination des informations que de nombreux Américains voient.

Le nouveau contrôle algorithmique

Rappelons que Schudson a critiqué le modèle de gatekeeping pour avoir « laissé l'information sociologiquement intacte ». Parce que les informations sont construites, et non préfabriquées, le modèle de gatekeeping ne tient pas compte de la complexité du processus de production des informations, affirmait Schudson. Cette critique, cependant, ne s'applique plus aux circonstances de plus en plus courantes dans lesquelles des sociétés telles que Google et Facebook, qui ne pratiquent pas elles-mêmes le journalisme, déterminent les nouvelles que les membres du public sont le plus susceptibles de voir — et les sujets d'actualité ou les organes d'information que ces publics ont peu de chances de rencontrer, à moins qu'ils ne les recherchent activement.

Dans ces cas, Google, Facebook et les autres sociétés de médias sociaux n'ont aucune influence ni aucun intérêt dans la production des articles que leurs algorithmes favorisent ou enterrent. Sans tenir compte des principes de base du journalisme éthique recommandés par la Society of Professional Journalists — rechercher la vérité et la rapporter, minimiser les dommages, agir de manière indépendante et être responsable et transparent — les nouveaux gardiens prétendent à la neutralité du contenu tout en promouvant des informations qui ne respectent souvent pas, de manière flagrante, une seule des directives éthiques de la SPJ.

Ce problème est aggravé par le fait qu'il est impossible pour une version contemporaine de David Manning White ou Walter Gieber d'étudier les processus de contrôle d'accès chez Google ou Facebook : Les algorithmes engagés dans le nouveau contrôle d'accès sont protégés de l'examen du public en tant que propriété intellectuelle exclusive. Comme Avril Anderson et moi-même l'avons précédemment rapporté, un recours collectif déposé contre YouTube en août 2019 par des créateurs de contenu LGBT pourrait « forcer Google à rendre ses puissants algorithmes disponibles pour un examen minutieux. » Google/YouTube ont cherché à rejeter l'affaire au motif que ses algorithmes de distribution ne sont « pas fondés sur le contenu. »

Algorithmes, agencement humain et inégalités

« Trust in the Future » par Ali Banisadr, huile sur lin, 82 x 120 pouces (2017). reproduit avec l'accord gracieux de l'artiste. <

<

Être responsable et transparent est l'un des principes directeurs du journalisme éthique, tel que le préconise la Society of Professional Journalists. Le filtrage des informations par des algorithmes propriétaires va à l'encontre de cette ligne de conduite éthique, ce qui menace gravement l'intégrité du journalisme et la probabilité d'un public bien informé.

Le plus souvent, lorsque Google, Facebook et d'autres entreprises de la Big Tech sont considérés par rapport au journalisme et aux conditions nécessaires pour qu'il remplisse son rôle fondamental de « quatrième pouvoir » — demander des comptes aux puissants et informer le public — l'accent est mis sur la façon dont la Big Tech s'est approprié les revenus publicitaires dont la plupart des médias traditionnels dépendent pour rester en activité. La montée en puissance du contrôle algorithmique des informations devrait être une préoccupation tout aussi importante.

Les technologies issues de l'intelligence artificielle réduisent le rôle de l'homme dans la prise de décision. Cet aspect est souvent présenté par les défenseurs de l'IA comme un argument de vente : Les algorithmes remplacent la subjectivité et la faillibilité humaines par des déterminations "objectives".

Les études critiques sur les préjugés algorithmiques - notamment Algorithms of Oppression de Safiya Umoja Noble, Automating Inequality de Virginia Eubank et Weapons of Math Destructionde Cathy O'Neill - nous conseillentde nous méfier de la facilité avec laquelle les préjugés humains de longue date sont intégrés dans des algorithmes "neutres" qui, à leur tour, ajoutent de nouvelles couches à des inégalités structurelles profondément enracinées.

Le nouveau contrôle algorithmique des informations se développant plus rapidement que la compréhension du public, les journalistes et les personnes concernées par le rôle du journalisme dans la démocratie sont confrontés à de multiples menaces. Nous devons exercer toute la pression possible pour forcer des sociétés telles que Google et Facebook à rendre leurs algorithmes disponibles pour un examen par des tiers ; en même temps, nous devons faire plus pour éduquer le public sur cette nouvelle et subtile ride dans le processus de production des nouvelles.

Les journalistes sont bien placés pour raconter cette histoire à partir d'une expérience de première main, et la réglementation gouvernementale ou les procès en cours pourraient éventuellement obliger les entreprises de la grande technologie à mettre leurs algorithmes à la disposition d'une tierce partie. Mais les enjeux sont trop importants pour que l'on attende sur la touche que d'autres résolvent le problème. Que pouvons-nous donc faire maintenant en réponse au gatekeeping algorithmique ? Je recommande quatre réponses proactives, présentées par ordre croissant d'engagement :

- Évitez d'utiliser « Google » comme un verbe, une habitude courante qui identifie tacitement une activité générique en ligne avec la marque d'une société qui a fait autant que n'importe qui pour multiplier l'inégalité épistémique, le concept développé par Shoshana Zuboff, auteur de The Age of Surveillance Capitalism, pour décrire une forme de pouvoir basée sur la différence entre ce que nous pouvons savoir et ce qui peut être connu de nous.

- N'oubliez pas que les moteurs de recherche et les flux de médias sociaux ne sont pas des sources d'information neutres. Les algorithmes qui les pilotent servent souvent à reproduire les inégalités existantes de manière subtile mais puissante. Enquêtez par vous-même. Sélectionnez un sujet qui vous intéresse et comparez les résultats de recherche de Google et de DuckDuckGo.

- Connectez-vous directement aux organismes de presse qui affichent un engagement ferme en faveur d'un journalisme éthique, plutôt que de vous fier à votre flux de médias sociaux pour obtenir des informations. Allez sur le site Web du média, inscrivez-vous à sa liste d'adresses électroniques ou à son flux RSS, abonnez-vous à sa version imprimée s'il en existe une. La connexion directe élimine la plateforme de médias sociaux, ou le moteur de recherche, comme un intermédiaire inutile et potentiellement partial.

- Signalez les biais algorithmiques lorsque vous les rencontrez. Signalez-le directement à l'entité qui en est responsable ; signalez-le publiquement en le faisant savoir aux autres.

Heureusement, notre cerveau humain peut utiliser de nouvelles informations d'une manière que les algorithmes ne peuvent pas faire. Comprendre les rôles influents des algorithmes dans nos vies — y compris la façon dont ils opèrent en tant que gardiens des nouvelles que nous sommes le plus susceptibles de voir — nous permet de mieux contrôler nos expériences individuelles en ligne. Sur la base d'une plus grande prise de conscience et d'un meilleur contrôle individuels, nous pouvons commencer à nous organiser collectivement pour dénoncer les biais et la censure algorithmiques et nous y opposer.

<

Excellent article. Une question connexe qui me vient à l'esprit est la disparition générale du journalisme, avec la diminution du nombre d'abonnés à des magazines comme Time et à des journaux comme le Los Angeles Times. Aujourd'hui, de nombreux Américains ne trouvent plus d'intérêt à payer pour les informations et, par extension, pour que les journalistes fassent leur travail. Comment le journalisme peut-il survivre dans cette nouvelle ère où le contenu de l'information est censé être gratuit ? Ces plateformes façonnent l'information grâce à leurs algorithmes, mais elles ont également créé cette nouvelle ère où les utilisateurs s'attendent à ce que l'information soit gratuite.